Элементы нейронных сетей

Искусственный нейрон (формальный нейрон) — элемент искусственных нейронных сетей, моделирующий некоторые функции биологического нейрона.

Главная функция искусственного нейрона — формировать выходной сигнал в зависимости от сигналов, поступающих на его входы.

В самой распространенной конфигурации входные сигналы обрабатываются адаптивным сумматором, затем выходной сигнал сумматора поступает в нелинейный преобразователь, где преобразуется функцией активации, и результат подается на выход (в точку ветвления ).

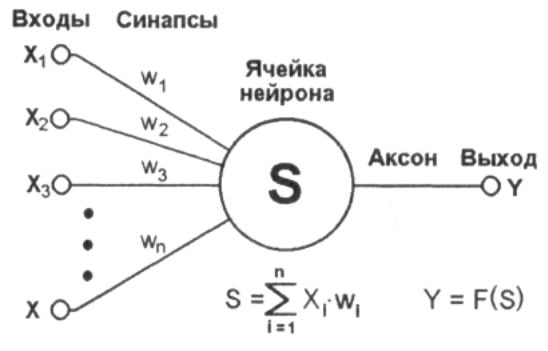

Общий вид искусственного нейрона приведен на рис. 11.1.

Рис.

11.1.

Искусственный нейрон

Нейрон характеризуется текущим состоянием и обладает группой синапсов — однонаправленных входных связей, соединенных с выходами других нейронов.

Нейрон имеет аксон — выходную связь данного нейрона, с которой сигнал (возбуждения или торможения) поступает на синапсы следующих нейронов.

Каждый синапс характеризуется величиной синаптической связи (ее весом wi).

Текущее состояние нейрона определяется как взвешенная сумма его входов:

Выход нейрона есть функция его состояния:

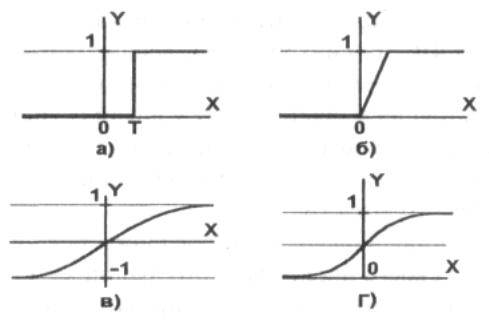

Активационная функция, которую также называют характеристической функцией, — это нелинейная функция, вычисляющая выходной сигнал формального нейрона.

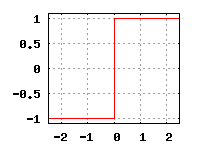

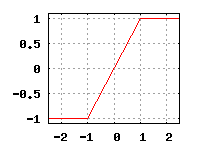

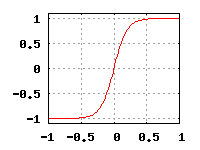

Часто используемые активационные функции:

- Жесткая пороговая функция.

- Линейный порог.

- Сигмоидальная функция.

Выбор активационной функции определяется спецификой поставленной задачи либо ограничениями, накладываемыми некоторыми алгоритмами обучения.

Нелинейный преобразователь — это элемент искусственного нейрона, преобразующий текущее состояние нейрона (выходной сигнал адаптивного сумматора) в выходной сигнал нейрона по некоторому нелинейному закону ( активационной функции ).

Точка ветвления (выход) — это элемент формального нейрона, посылающий его выходной сигнал по нескольким адресам и имеющий один вход и несколько выходов.

На вход точки ветвления обычно подается выходной сигнал нелинейного преобразователя, который затем посылается на входы других нейронов.

Основные модели и методы теории искусственных нейронных сетей.

Е.С.Борисов

среда, 19 октября 2005 г.

1 Введение

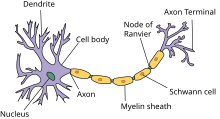

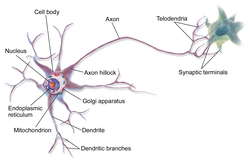

Математическая теория искусственных нейронных сетей многие идеи берёт из

нейробиологической теории, согласно которой нервная система человека

состоит из двух типов клеток — нейронов и нейроглии.

Нейроглия (глиальные или шванновские клетки) окружает нервные

клетки. В настоящее время глиальные клетки мало изучены. Считается, что

они выполняет опорную, разграничительную и защитную функции. Глиальных

клеток примерно в 10 раз больше чем нейронов. Они образуют т.н. миелиновую

оболочку, которая снабжает аксон (отросток нейрона) метаболическими

продуктами, компенсируя его удаленность от тела клетки.

Нейроны (нервные клетки) получают и передают электрохимические

сигналы. Нейрон может обладать разными размерами и формой, но схематически

его можно представить как шаровидное образование с отростками

(рис.1).

|

|

Составные части нейрона :

- Перикарион или сома — тело клетки, содержащее ядро.

- Дендриты — отростки, проводящие импульсы к телу нейрона. Они, как правило, короткие, широкие и сильно ветвятся.

- Аксон — отросток по которому нервный импульс распространяется от нейрона к другим клеткам. Аксон всегда один и может достигать длинны до 1м. На своем конце аксон может ветвится.

- Синапс — область где конечная ветка аксона контактирует с поверхностью сомы или дендрита другого нейрона. Различают возбуждающие синапсы, которые передают импульсы, активизирующей нейрон, и тормозящие синапсы, которые передают импульсы, тормозящие активность нейрона.

Возбуждение нейрона начинается в дендритах (или соме) и распространяется

вдоль по аксону, вызывая в итоге возбуждение в других нейронах. Таким

образом нейроны образуют сеть.

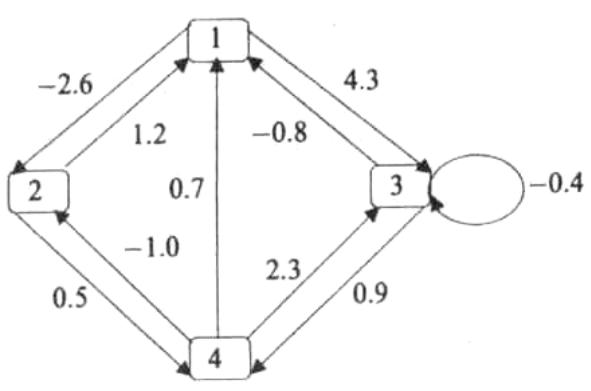

2 Искусственная нейронная сеть

Искусственная нейронная сеть это совокупность нейронных

элементов и связей между ними [1].

|

|

Основу каждой искусственной нейронной сети составляют относительно

простые, в большинстве случаев — однотипные, элементы (ячейки), имитирующие

работу нейронов мозга (рис.2), далее под нейроном

мы будем подразумевать искусственный нейрон, ячейку искусственной нейронной сети.

- Нейрон обладает группой синапсов — однонаправленных входных

связей, соединенных с выходами других нейронов. Каждый синапс характеризуется

величиной синаптической связи или ее весом wi. - Каждый нейрон имеет текущее состояние, которое обычно определяется, как

взвешенная сумма его входов: - Нейрон имеет аксон — выходную связь данного нейрона,

с которой сигнал (возбуждения или торможения) поступает на

синапсы следующих нейронов. Выход нейрона есть функция его

состояния:y = f(s)

Функция f называется функцией активации.

Примеры такой функции приведены на рис. 3.

|

Множество всех нейронов искусственной нейронной сети можно разделить на

подмножества — т.н. слои. Взаимодействие нейронов происходит послойно.

Слой искусственной нейронной сети это множество нейронов на

которые в каждый такт времени параллельно поступают сигналы от других

нейронов данной сети [1].

Выбор архитектуры искусственной нейронной сети определяется задачей. Для

некоторых классов задач уже существуют оптимальные конфигурации.

Если же задача не может быть сведена ни к одному из известных классов,

разработчику приходится решать задачу синтеза новой конфигурации.

Проблема синтеза искусственной нейронной сети сильно зависит от задачи,

дать общие подробные рекомендации затруднительно. В большинстве

случаев оптимальный вариант искусственной нейронной сети получается

опытным путем[2].

Искусственные нейронные сети могут быть программного и аппаратного

исполнения. Реализация аппаратная обычно представляет собой параллельный

вычислитель, состоящий из множества простых процессоров [3].

Важной особенностью искусственной нейронной сети есть возможность её

обучения. Обычно процесс обучения сводится к корректировке весовых

коэффициентов. Алгоритмы обучения искусственных нейронных сетей можно

разделить на два класса:

- обучение с учителем — сети предъявляются значения как входных, так и желательных выходных сигналов, и система по определенному алгоритму подстраивает веса своих синаптических связей.

- обучение без учителя — веса изменяются по алгоритму, учитывающему только входные и производные от них сигналы.

3 Обучение с учителем

Технология обучения »с учителем» искусственной нейронной сети обычно предполагает

наличие двух однотипных множеств:

- Множества учебных примеров, которое используется для »настройки» сети.

- Множества контрольных примеров, которое используется для оценки качества работы сети.

Элементами этих двух множеств есть пары ( X, YI ), где

- X — вход, для обучаемой нейронной сети;

- YI — идеальный (желаемый) выход сети для входа X;

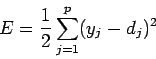

Так же определяется функция ошибки E.

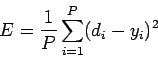

Обычно это средняя квадратичная ошибка [3]:

где

- P — количество обработанных нейронной сетью примеров;

- yi — реальный выход нейронной сети;

- di — желаемый (идеальный) выход нейронной сети;

Процедура обучения искусственной нейронной сети сводится к процедуре

коррекции весов её связей. Целью процедуры коррекции весов есть минимизация функции ошибки E.

Общая схема обучения «с учителем» выглядит так :

- Весовые коэффициенты нейронной сети устанавливаются некоторым образом, обычно — малыми случайными значениями.

- На вход нейронной сети в определенном порядке

подаются учебные примеры. Для каждого примера вычисляется ошибка

EL (ошибка обучения) и по определенному алгоритму

производится коррекция весов. Целью процедуры коррекции весов есть

минимизация ошибки EL. - Проверка правильности работы сети — на вход в определенном порядке

подаются контрольные примеры. Для каждого примера вычисляется

ошибка EG

(ошибка обобщения). Если результат неудовлетворительный то, производится

модификация множества учебных примеров или архитектуры сети и повторение

цикла обучения.

Если после нескольких итераций алгоритма обучения ошибка обучения

EL

падает почти до нуля, в то время как ошибка обобщения

EG

в начале

спадает а затем начинает расти, то это признак эффекта переобучения.

В этом случае обучение необходимо прекратить.

3.1 Метод Розенблатта

В случае однослойной сети желаемые выходные значения нейронов единственного

слоя известны, и подстройка весов синаптических связей идет в направлении,

минимизирующем ошибку на выходе сети.

По этому принципу построен алгоритм Розенблатта. Данный метод был

предложен Ф.Розенблаттом в 1959 г. для искусственной нейронной сети,

названной персептрон (perceptron)[4]. Персептрон имеет

пороговую функцию активации, его схема представлена

здесь.

Правило обучения для персептрона выглядит так [1] :

|

wij(t+1) = wij(t) + a * xi * dj |

(1) |

где

- xi — i-тый вход искусственной нейронной сети

- dj — желаемый (идеальный) j-тый выход нейронной сети

- a — коэффициент (скорость обучения) 0 < a ≤ 1

Весовые коэффициенты меняются только в том случае, если реальное выходное

значение не совпадает идеальным выходным значением.

3.2 Метод Видроу-Хоффа

Персептрон Розенблатта ограничивается бинарными выходами. Видроу и Хофф

изменили модель Розенблатта. Их первая модель — ADALINE (Adaptive Linear

Element) имела один выходной нейрон и непрерывную линейную функцию

активации нейронов[6].

|

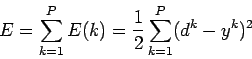

(2) |

Метод обучения Видроу-Хоффа известен еще как дельта-правило

(delta-rule). Этот метод ставит своей целью минимизацию функции ошибки

E в пространстве весовых коэффициентов.

|

(3) |

где

- P — количество обработанных и сетью примеров

- E(k) — ошибка для k-го примера

- yk — реальный выход сети для k-го примера

- dk — желаемый (идеальный) выход сети для k-го примера

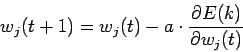

Минимизация E осуществляется методом градиентного спуска

где

Таким образом весовые коэффициенты изменяются по правилу

|

wj(t+1)=wj(t) — a * (yk-dk)* xjk |

(4) |

На рис.4 изображён пример результатов работы линейного классификатора на основе ADALINE.

|

|

Реализация ADALINE в системе Octave

[ здесь ].

3.3 Метод обратного распространения

Сеть, имеющую два и более слоёв, уже проблематично обучить описанными

выше методами, поскольку в многослойных сетях известен выход лишь

последнего слоя нейронов.

Решение этой задачи был предложено Д.Румельхартом с соавторами в 1986

году[5]. Предложенный метод обучения многослойной искусственной

нейронной сети, был назван методом обратного распространения

ошибки. Основная идея этого метода состояла в распространение сигналов ошибки

от выходов сети к её входам, в направлении, обратном прямому распространению

сигналов в обычном режиме работы.

Метод обратного распространения ошибки (error back propagation) это

итеративный градиентный алгоритм обучения многослойной искусственной

нейронной сети без обратных связей [5,3]. При

обучении ставится задача минимизации функции ошибки:

|

(5) |

где

- yj — реальное значение j-того выхода сети;

- dj — идеальное (желаемое) значение j-того выхода сети;

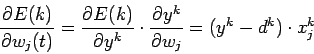

Минимизация E ведется методом градиентного спуска. Подстройка весовых

коэффициентов происходит следующим образом:

|

(6) |

где

- wij

— весовой коэффициент синаптической связи, соединяющей i-ый и j-ый узлы сети; - 0 < h <1 — коэффициент скорости обучения;

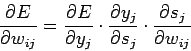

- Второй множитель (6)

(7) Здесь

- yj — выход нейрона номер j,

- sj — взвешенная сумма его входных сигналов, то есть аргумент активационной функции.

- Первый множитель в (7) раскладывается следующим образом:

(8) где k число нейронов слоя n+1

- Второй множитель (7)

есть производная активационной функции по ее аргументу. Из этого следует, что производная активационной функции должна быть определена на всей оси абсцисс. Таким образом — функция единичного скачка и прочие активационные функции с неоднородностями не подходят. В данном случае применяются гладкие функции — гиперболический тангенс или классический сигмоид с экспонентой.

- Третий множитель (7)

,

есть выход i-того нейрона предыдущего слоя.

Введя новую переменную

![begin{displaymath}

delta_j^{[n]}=

frac{partial E}{partial y_j}cdot

frac{partial y_j}{partial s_j}

end{displaymath}](http://mechanoid.su/content/neural-net-base.html/img47.png) |

(9) |

мы получим рекурсивную формулу для расчетов величин

слоя n из величин

слоя n+1.

![begin{displaymath}

delta_j^{[n]}=

frac{d y_j}{d s_j}cdot

sumlimits_k delta_k^{[n+1]} w_{jk}^{[n+1]}

end{displaymath}](http://mechanoid.su/content/neural-net-base.html/img51.png) |

(10) |

Для выходного слоя

| (11) |

Теперь мы можем записать (6) в раскрытом виде:

| (12) |

4 Обучение без учителя

Для методов обучения »без учителя», так же как и методов обучения »с

учителем», требуется множество учебных примеров. Процесс обучения,

как и в случае обучения »с учителем», сводится к подстраиванию весовых

коэффициентов. Но в отличии от обучения »с учителем», здесь нет

эталонных выходов и веса изменяются по алгоритму, учитывающему только

входные и производные от них сигналы.

4.1 Метод Хебба

Метод Хебба основывается на биологическом феномене обучения путем

повторения и привыкания. Этот феномен еще известен как эффект

проторения[7].

При обучении искусственной нейронной сети сигнальным методом Хебба[8]

усиливаются связи между возбужденными нейронами, в данном случае веса

изменяются по следующему правилу:

| wij(t+1)=wij(t)+a * yi[n-1] * yj[n] | (13) |

где

- yi[n-1] выходное значение нейрона i слоя n-1;

- yj[n] выходное значение нейрона j слоя n;

-

wij(t) и wij(t-1) весовой коэффициент

синапса, соединяющего эти нейроны, на итерациях

t и t-1 соответственно; - a — коэффициент скорости обучения.

Существует также дифференциальный метод обучения Хебба.

|

wij(t+1)=wij(t) + a * ( yi[n-1](t) — yi[n-1](t-1) ) * ( yj[n](t) — yj[n](t-1) ) |

(14) |

Здесь

- yi[n-1](t) и yi[n-1](t-1)

выходное значение нейрона i

слоя n-1 соответственно на итерациях t

и t-1; - yj[n](t) и yj[n](t-1)

то же самое для нейрона j

слоя n.

Как видно из (14), сильнее всего обучаются синапсы, соединяющие

те нейроны, выходы которых наиболее динамично изменились в сторону

увеличения.

Литература

- 1

- В.А.Головко, под ред.проф.А.И.Галушкина Нейронные сети: обучение, организация и применение. — Москва : ИПРЖР, 2001

- 2

- С.Короткий Нейронные сети — http://lii.newmail.ru

- 3

- Л.Г.Комарцова, А.В. Максимов Нейрокомпьютеры. — Москва : МГТУ им. Н.Э.Баумана, 2002

- 4

- F.Rosenblatt Principles of Neurodinamics. — New York: Spartan Books,1962.

Русский перевод:

Ф.Розенблатт Принципы нейродинамики. — Москва : Мир, 1965. - 5

- D.E.Rumelhart, G.E.Hinton, R.J.Williams Learning internal representations by error propagation. // In Parallel distributed processing, vol. 1, pp. 318-62. Cambridg, MA: MIT Press, 1986.

- 6

- В.Widrow, M.Hoff Adaptive switching circuits. // IRE WESCON Convention Record, part 4, pp. 96-104. New York: Institute of Radio Engineers, 1960.

- 7

- Ю.И.Петунин Приложение теории случайных процессов в биологии и медицине. — Киев : Наукова Думка, 1981.

- 8

- D.O.Hebb Organization of behavior. — New York: Science Editions, 1949.

Evgeny S. Borisov

2005-10-19

При использовании материалов этого сайта, пожалуйста вставляйте в свой текст ссылку на мою статью.

Представим перечень основных терминов, используемых в теории и практике нейронных сетей.

Нейрон – neuron – базовый элемент нейронных сетей. Имеет входы, снабженные весами, смещение, суммирующий элемент и выходную активационную функцию. Является аналогом биологического нейрона. Нейрон выполняет функцию адаптивного сумматора с варьируемыми входными весовыми коэффициентами, суммарный выходной сигнал которого подвергается линейной или нелинейной обработке, образуя итоговый выходной сигнал.

Адалина – ADALINE (ADAptive LINear Element) – одно из наименований для линейного нейрона, для которого активационная функция – линейная.

Мадалина – простейшая однослойная линейная искусственная нейронная сеть, состоящая из адалин.

Смещение – bias – параметр нейрона, который суммируется со взвешенными входами нейрона, образуя текущее состояние нейрона – входную величину (аргумент) для функции активации нейрона.

Активационная (передаточная) функция – activation (transfer) function – функция линейного или нелинейного преобразования состояния нейрона. Эта функция преобразует сумму взвешенных входов нейрона в его выход.

Синапс – synapse – однонаправленная линейная связь, характерная для каждого из сумматоров, служащая для обозначения направления распространения сигнала, который умножается на заданный синаптический весовой коэффициент.

Аксон – axon – выходная связь данного нейрона, с которой сигнал (возбуждения или торможения) поступает на синапсы следующих нейронов.

Архитектура – architecture – описание числа слоев в нейронной сети, передаточных (активационных) функций каждого слоя, числа нейронов в каждом слое и связей между слоями.

Узел – unit – отдельный нейрон в нейронной сети, имеющий, как правило, несколько сигналов на входе и лишь один выходной сигнал. Термин «узел» используется обычно для обозначения и представления единичного нейрона в структуре нейронной сети; в рамках графовой модели нейронной сети эквивалентен вершине графа.

Слой – layer – множество нейронов (узлов), имеющих общие входные или выходные сигналы.

Входной слой – input layer – слой нейронов (узлов), образованный совокупностью элементов, на входы которых подаются входные данные нейронной сети.

Скрытый (промежуточный) слой – hidden layer – слой, содержащий нейроны (узлы), на которые не поступают входные данные и с которых не считываются выходные данные нейронной сети.

Выходной слой – output layer – слой нейронов (узлов), выходные сигналы которых образуют выходной сигнал нейронной сети.

Нейронная сеть – neural network – структура соединенных между собой нейронов, которая характеризуется топологией, свойствами узлов, а также правилами обучения или тренировки для получения желаемого выходного сигнала.

Персептрон – perceptron – простейшая форма нейронной сети. В основном под перcептроном понимают элементарный нейрон, представляющий собой линейный сумматор, каждый из входных сигналов которого умножается на некоторый весовой множитель, а выходной суммарный сигнал является ненулевым, если сумма превышает некоторое пороговое значение. Иногда перcептроном называют любую НС слоистой структуры. Однако здесь и далее под перcептроном понимается только однослойная (single-layer perceptron) или многослойная (multilayer perceptron) сеть, состоящая из нейронов с активационными функциями единичного скачка (бинарная сеть).

Сеть с прямыми связями (сеть без обратных связей) – feedforward network – многослойная сеть, в которой каждый слой своими входами имеет выходы только предшествующих слоев.

Сеть с обратной связью – feedback network – сеть с соединениями с выхода сети на ее вход.

Соединение обратной связи может охватывать различные слои.

Рекуррентная нейронная сеть – recurrent neural network – нейронная сеть, которая отличается от сети с прямыми связями (feedforward network) наличием, по крайней мере, одной петли обратной связи.

Обучение (тренировка) – learning (training) – этап функционирования нейронной сети, в процессе которого на ее вход поочередно поступают данные из обучающего набора с целью корректировки весовых коэффициентов синаптических связей для получения наиболее адекватного сигнала на выходе нейронной сети.

Обучение в режиме реального времени – on-line training – модификация алгоритма обучения, когда веса и смещения сети корректируются после предъявления каждого нового образа (вектора) обучающей последовательности.

Обучение в предварительном режиме – off-line training – разновидность алгоритма обучения, когда коррекция весов и смещений производится один раз за период обучения – после предъявления всех векторов обучающей последовательности («пачки» векторов, batch).

Образец (эталон) – pattern – «правильный» результат на выходе нейронной сети. Совокупность всех эталонов вместе с входным набором данных (фактов) образует обучающее множество данных.

Обучение с учителем – supervised learning – процесс обучения нейронной сети, непременным требованием которого является существование готового обучающего набора данных.

Обучение без учителя – unsupervised learning – процесс обучения нейронной сети, при котором наличие набора эталонов отсутствует.

Обратное распространение – backpropagation – наиболее применяемый способ управляемого обучения, при котором сигнал ошибки на выходе нейронной сети распространяется в обратном направлении: от нейронов выходного слоя к нейронам входного слоя с последующей корректировкой синаптических весов нейронной сети для достижения минимальной выходной погрешности.

Обратное распространение в автономном режиме – backpropagation batch – разновидность алгоритма обучения с обратным распространением ошибки, когда коррекция весов и смещений производится один раз за период обучения – после предъявления всех векторов обучающей последовательности («пачки» векторов, batch).

Обратное распространение в режиме реального времени – backpropagation on-line – модификация алгоритма обучения по методу обратного распространения ошибки, когда веса и смещения сети корректируются после предъявления каждого нового образа (вектора) обучающей последовательности.

Тестирование – testing – этап проверки работоспособности нейронной сети, в течение которого на вход сети подаются данные, которые не были использованы в процессе обучения, но входные эталоны для которых известны, что позволяет оценить выходную погрешность обученной нейронной сети. В процессе тестирования весовые коэффициенты нейронной сети не изменяются.

Обобщение – generalization – способность нейронной сети давать статистически корректный ответ для входных сигналов, которые принадлежат классу обучающих данных, но не были использованы ни на этапе обучения, ни на этапе тестирования.

Запоминание – storing – способность нейронной сети при увеличении ее размерности выделять случайные особенности в данных, которые, тем не менее, могут не отражать истинный характер отображения «вход-выход». Нейронные сети, обладающие высокой способностью запоминания, могут иметь пониженные возможности обобщения.

Переобучение – overfitting – ситуация, когда на обучающей последовательности ошибки сети были очень малы, но на новых данных становятся большими.

Здравствуйте. Меня зовут Андрей, я frontend-разработчик и я хочу поговорить с вами на такую тему как нейросети. Дело в том, что ML технологии все глубже проникают в нашу жизнь, и о нейросетях сказано и написано уже очень много, но когда я захотел разобраться в этом вопросе, я понял что в интернете есть множество гайдов о том как создать нейросеть и выглядят они примерно следующим образом:

-

Берем Tensorflow

-

Создаем нейросеть

Более подробная информация разбросана кусками по всему интернету. Поэтому я постарался собрать ее воедино и изложить в этой статье. Сразу оговорюсь, что я не являюсь специалистом в области ML или биологии, поэтому местами могу быть не точным. В таком случае буду рад вашим комментариям.

Пока я писал эту статью я понял, что у меня получается довольно объемный лонгрид, поэтому решил разбить ее на несколько частей. В первой части мы поговорим о теории, во второй напишем собственную нейросеть с нуля без использования каких-либо библиотек, в третьей попробуем применить ее на практике.

Так как это моя первая публикация, появляться они будут по мере прохождения модерации, после чего я добавлю ссылки на все части. Итак, приступим.

Для чего нужны нейросети

Нейросети встречаются везде. Основная их функция — это управление различными частями организма в зависимости от изменения окружающих условий. В качестве примера можно рассмотреть механизм сужения и расширения зрачка в зависимости от уровня освещения.

В нашем глазу есть сенсоры, которые улавливают количество света попадающего через зрачок на заднюю поверхность глаза. Они преобразуют эту информацию в электрические импульсы и передают на прикрепленные к ним нервные окончания. Далее это сигнал проходит по всей нейронной сети, которая принимает решение о том, не опасно ли такое количество света для глаза, достаточно ли оно для того, чтобы четко распознавать визуальную информацию, и нужно ли, исходя из этих факторов, уменьшить или увеличить количество света.

На выходе этой сети находятся мышцы, отвечающие за расширение или сужение зрачка, и приводят эти механизмы в действие в зависимости от сигнала, полученного из нейросети. И таких механизмов огромное количество в теле любого живого существа, обладающего нервной системой.

Устройство нейрона

Нейросети встречаются в природе в виде нервной системы того или иного существа. В зависимости от выполняемой функции и расположения, они делятся на различные отделы и органы, такие как головной мозг, спинной мозг, различные проводящие структуры. Но все их объединяет одно — они состоят из связанных между собой структурно-функциональных единиц — клеток нейронов.

Нейрон условно можно разделить на три части: тело нейрона, и его отростки — дендриты и аксон.

Дендриты нейрона создают дендритное дерево, размер которого зависит от числа контактов с другими нейронами. Это своего рода входные каналы нервной клетки. Именно с их помощью нейрон получает сигналы от других нейронов.

Тело нейрона в природе, достаточно сложная штука, но именно в нем все сигналы, поступившие через дендриты объединяются, обрабатываются, и принимается решение о том передавать ли сигнал далее, и какой силы он должен быть.

Аксон — это выходной интерфейс нейрона. Он крепится так называемыми синапсами к дендриту другого нейрона, и по нему сигнал, выходящий из тела нейрона, поступает к следующей клетке нашей нейросети.

Нейросети в IT

Что же, раз механизм нам понятен, почему бы нам не попробовать воспроизвести его с помощью информационных технологий?

Итак, у нас есть входной слои нейронов, которые, по сути, являются сенсорами нашей системы. Они нужны для того, чтобы получить информацию из окружающей среды и передать ее дальше в нейросеть.

Также у нас есть несколько слоев нейронов, каждый из которых получает информацию от всех нейронов предыдущего слоя, каким-то образом ее обрабатывают, и передают на следующий слой.

И, наконец, у нас есть выходные нейроны. Исходя из сигналов, поступающих от них, мы можем судить о принятом нейросетью решении.

Такой простейший вариант нейронной сети называется перцептрон, и именно его мы с вами и попробуем воссоздать.

Все нейроны по сути одинаковы, и принимают решение о том, какой силы сигнал передать далее с помощью одного и того же алгоритма. Это алгоритм называется активационной функцией. На вход она получает сумму значений входных сигналов, а на выход передает значение выходного сигнала.

Но в таком случае, получается, что все нейроны любого слоя будут получать одинаковый сигнал, и отдавать одинаковое значение. Таким образом мы могли бы заменить всю нашу сеть на один нейрон. Чтобы устранить эту проблему, мы присвоим входу каждого нейрона определенный вес. Этот вес будет обозначать насколько важен для каждого конкретного нейрона сигнал, получаемый от другого нейрона. И тут мы подходим к самому интересному.

Обучение нейронной сети — это процесс подбора входных весов для каждого нейрона таким образом, чтобы на выходе получить сигнал максимально соответствующий ожиданиям.

То есть мы подаем на вход нейросети определенные данные, для которых мы знаем, каким должен быть результат. Далее мы сравниваем результат, который нам выдала нейросеть с ожидаемым результатом, вычисляем ошибку, и корректируем веса нейронов таким образом, чтобы эту ошибку минимизировать. И повторяем это действие большое количество раз для большого количества наборов входных и выходных данных, чтобы сеть поняла какие сигналы на каком нейроне ей важны больше, а какие меньше. Чем больше и разнообразнее будет набор данных для обучения, тем лучше нейросеть сможет обучиться и впоследствии давать правильный результат. Этот процесс называется обучением с учителем.

Добавим немного математики.

В качестве активационной функции нейрона может выступать любая функция, существующая на всем отрезке значений, получающихся на выходе нейрона и входных данных. Для нашего примера мы возьмем сигмоиду. Она существует на отрезке от минус бесконечности до бесконечности, плавно меняется от 0 до 1 и имеет значение 0,5 в точке 0. Идеальный кандидат. Выглядит она следующим образом:

Таким образом наш нейрон сможет принимать любую сумму значений всех входящих сигналов и на выходе будет выдавать значение от 0 до 1. Это хорошо подходит для принятия бинарных решений, и мы условимся, что если число на выходе нейросети > 0.5, мы будем расценивать его как истину, иначе — как ложь.

Итак, давайте рассмотрим пример с топологией сети рассмотренной выше. У нас есть три входных нейрона со значениями ИСТИНА, ЛОЖЬ и ИСТИНА соответственно, два нейрона в среднем слое нейросети (эти слои также называют скрытыми), и один выходной нейрон, который сообщит нам о решении, принятом нейросетью. Так как наша сеть еще не обучена, поэтому значения весов на входах нейронов мы возьмем случайными в диапазоне от -0,5 до 0,5.

Таким образом сумма входных значений первого нейрона скрытого слоя будет равна

1 * 0,43 + 0 * 0,18 + 1 * -0,21 = 0,22

Передав это значение в активационную функцию, мы получим значение, которое наш нейрон передаст далее по сети в следующий слой.

sigmoid(0,22) = 1 / (1 + e^-0,22) = 0,55

Аналогичные операции произведём для второго нейрона скрытого слоя и получим значение 0,60.

И, наконец, повторим эти операции для единственного нейрона в выходном слое нашей нейросети и получим значение 0,60, что мы условились считать как истину.

Пока что это абсолютно случайное значение, так как веса мы выбирали случайно. Но, предположим, что мы знаем ожидаемое значение для такого набора входных данных и наша сеть ошиблась. В таком случае нам нужно вычислить ошибку и изменить параметры весов, таким образом немного обучив нашу нейросеть.

Первым делом рассчитаем ошибку на выходе сети. Делается это довольно просто, нам просто нужно получить разницу полученного значения и ожидаемого.

error = 0.60 — 0 = 0.60

Чтобы узнать насколько нам надо изменить веса нашего нейрона, нам нужно величину ошибки умножить на производную от нашей активационной функции в этой точке. К счастью, производная от сигмоиды довольно проста.

Таким образом наша дельта весов будет равна

delta = 0.60 * (1 — 0.60) = 0.24

Новый вес для входа нейрона рассчитывается по формуле

weight = weight — output * delta * learning rate

Где weight — текущий вес, output — значение на выходе предыдущего нейрона, delta — дельта весов, которую мы рассчитали ранее и learning rate — значение, подбираемое экспериментально, от которого зависит скорость обучения нейросети. Если оно будет слишком маленьким — нейросеть будет более чувствительна к деталям, но будет обучаться слишком медленно и наоборот. Для примера возьмем learning rate равным 0,3. Итак новый вес для первого входа выходного нейрона будет равен:

w = 0,22 — 0,55 * 0,24 * 0,3 = 0,18

Аналогичным образом рассчитаем новый вес для второго входа выходного нейрона:

w = 0.47 — 0.60 * 0.24 * 0.3 = 0.43

Итак, мы скорректировали веса для входов выходного нейрона, но чтобы рассчитать остальные, нам нужно знать ошибку для каждого из нейронов нашей нейросети. Это делается не так очевидно как для выходного нейрона, но тоже довольно просто. Чтобы получить ошибку каждого нейрона нам нужно новый вес нейронной связи умножить на дельту. Таким образом ошибка первого нейрона скрытого слоя равна:

error = 0.18 * 0.24 = 0.04

Теперь, зная ошибку для нейрона, мы можем произвести все те же самые операции, что провели ранее, и скорректировать его веса. Этот процесс называется обратным распространением ошибки.

Итак, мы знаем как работает нейрон, что такое нейронные связи в нейросети и как происходит процесс обучения. Этих знаний достаточно чтобы применить их на практике и написать простейшую нейросеть, чем мы и займемся в следующей части статьи.

Искусственный

нейрон

имитирует в первом приближении свойства

биологического нейрона. Он обладает

группой

синапсов

– однонаправленных входных свзей,

соединенных с выходами других нейронов,

а также имеет

аксон

– выходную связь данного нейрона, с

которой сигнал (возбуждения или

торможения) поступает на синапсы

следующих нейронов. Каждый вход

умножается на соответствующий вес,

аналогичный синаптической силе, и все

произведения суммируются, определяя

уровень активации нейрона.

Общий

вид нейрона

на рис. 2.4. Здесь множество входных

сигналов обозначены вектором X. Каждый

вес w, соответствует «силе»

одной биологической синаптической

связи. Множество весов в совокупности

обозначается вектором W.

Рис.

2.4. Искусственный нейрон

Нейронная

сеть

является совокупностью элементов,

соединенных

некоторым образом так, чтобы между ними

обеспечивалось взаимодействие.

Эти

элементы,

называемые также нейронами

или

узлами,

представляют

собой простые процессоры, вычислительные

возможности которых обычно ограничиваются

некоторым правилом комбинирования

входных сигналов и правилом

активизации,

позволяющим вычислить выходной сигнал

по совокупности входных сигналов.

Выходной

сигнал элемента

может посылаться другим элементам по

взвешенным связям,

с

каждой из которых связан весовой

коэффициент или

вес.

В

зависимости от значения весового

коэффициента передаваемый сигнал или

усиливается, или подавляется.

Структура

связей

отражает детали конструкции сети, а

именно то, какие элементы соединены, в

каком направлении работают соединения,

и каков уровень значимости (т.е. вес)

каждого из соединений. Задача, которую

понимает сеть (или ее программа),

описывается в терминах весовых значений

связей, связывающих элементы.

Структура

связей обычно определяется в два этапа:

сначала

разработчик системы указывает, какие

элементы должны быть связаны, и в каком

направлении, а затем в процессе фазы

обучения определяются значения

соответствующих весовых коэффициентов.

Весовые

коэффициенты

можно определить и без проведения

обучения, но как раз самое большое

преимущество нейронных сетей заключается

в их способности обучаться выполнению

задачи на основе тех данных, которые

сеть будет получать в процессе реальной

работы.

Существует

множество различных типов

нейронных сетей,

обладающих рядом общих характеристик,

которые можно представить с помощью

следующих абстракций:

• элемент

сети;

• структура

связей;

• правило

распространения сигналов в сети;

• правило

комбинирования входящих сигналов;

• правило

вычисления сигнала активности;

• правило

обучения, корректирующее связи.

Структура

связей

отражает то, как соединены элементы

сети.

В

одной модели

(т.е. для одного типа сетей) каждый

элемент может быть связан со всеми

другими элементами сети,

в

другой модели

элементы могут быть организованы в

некоторой упорядоченной по уровням

(слоям) иерархии, где связи допускаются

только между элементами в смежных

слоях,

а в

третьей

— могут допускаться обратные связи

между смежными слоями или внутри одного

слоя, или же допускаться посылка сигналов

элементами самим себе.

Каждая

связь определяется тремя параметрами:

-элементом,

от которого исходит данная связь,

-элементом,

к которому данная связь направлена,

-и

числом (обычно действительным),

указывающим весовой коэффициент (т.е.

вес связи).

Отрицательное

значение веса соответствует подавлению

активности соответствующего элемента,

а положительное

значение — усилению

его активности. Абсолютное

значение

весового коэффициента характеризует

силу связи.

Вычисление

сигнала активации

Для

всех элементов имеется правило

вычисления выходного значения,

которое предполагается передать другим

элементам или во внешнюю среду (если

речь идет о выходном элементе,

представляющем конечный результат

вычислений). Это правило называют

функцией

активности

(или

функцией

активации),

а

соответствующее выходное значение

называют активностью

соответствующего

элемента.

Активность

может представляться

либо некоторым действительным значением

произвольного вида, либо действительным

значением из некоторого ограниченного

интервала значений (например, из

интервала [0, 1]), или же некоторым значением

из определенного дискретного набора

значений (например, {0, 1} или {+1,-1}).

На

вход функции активности поступает

значение комбинированного ввода данного

элемента.

Активационная

функция может иметь различный вид (рис.

2.9).

В

случае, когда функция активности одна

и та же для всех нейронов сети, сеть

называют однородной

(гомогенной).

Если

же она зависит еще от одного или

не-скольких параметров, значения которых

меняются от нейрона к нейрону, то сеть

называют неоднородной

(гетерогенной).

Рис.

2.9. Типы активационных функций:

а –

функция единичного скачка; б – линейный

порог (гистерезис); в – сигмоид –

гиперболический тангенс; г – сигмоид

– формула

Одной

из наиболее распространенных

является нелинейная функция с насыщением,

так называемая логистическая функция

или сигмоид

(т.е. функция

S-образного вида). Она обладает свойством

усиливать слабые сигналы лучше, чем

сильные, и предотвращает насыщение от

сильных сигналов.

Другой

широко используемой

активационной функцией является

гиперболический

тангенс.

В отличие от логистической функции

гиперболический тангенс принимает

значения различных знаков, что для ряда

сетей оказывается выгодным.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

| Axon | |

|---|---|

An axon of a multipolar neuron |

|

| Identifiers | |

| MeSH | D001369 |

| FMA | 67308 |

| Anatomical terminology

[edit on Wikidata] |

An axon (from Greek ἄξων áxōn, axis), or nerve fiber (or nerve fibre: see spelling differences), is a long, slender projection of a nerve cell, or neuron, in vertebrates, that typically conducts electrical impulses known as action potentials away from the nerve cell body. The function of the axon is to transmit information to different neurons, muscles, and glands. In certain sensory neurons (pseudounipolar neurons), such as those for touch and warmth, the axons are called afferent nerve fibers and the electrical impulse travels along these from the periphery to the cell body and from the cell body to the spinal cord along another branch of the same axon. Axon dysfunction can be the cause of many inherited and acquired neurological disorders that affect both the peripheral and central neurons. Nerve fibers are classed into three types – group A nerve fibers, group B nerve fibers, and group C nerve fibers. Groups A and B are myelinated, and group C are unmyelinated. These groups include both sensory fibers and motor fibers. Another classification groups only the sensory fibers as Type I, Type II, Type III, and Type IV.

An axon is one of two types of cytoplasmic protrusions from the cell body of a neuron; the other type is a dendrite. Axons are distinguished from dendrites by several features, including shape (dendrites often taper while axons usually maintain a constant radius), length (dendrites are restricted to a small region around the cell body while axons can be much longer), and function (dendrites receive signals whereas axons transmit them). Some types of neurons have no axon and transmit signals from their dendrites. In some species, axons can emanate from dendrites known as axon-carrying dendrites.[1] No neuron ever has more than one axon; however in invertebrates such as insects or leeches the axon sometimes consists of several regions that function more or less independently of each other.[2]

Axons are covered by a membrane known as an axolemma; the cytoplasm of an axon is called axoplasm. Most axons branch, in some cases very profusely. The end branches of an axon are called telodendria. The swollen end of a telodendron is known as the axon terminal which joins the dendron or cell body of another neuron forming a synaptic connection. Axons make contact with other cells – usually other neurons but sometimes muscle or gland cells – at junctions called synapses. In some circumstances, the axon of one neuron may form a synapse with the dendrites of the same neuron, resulting in an autapse. At a synapse, the membrane of the axon closely adjoins the membrane of the target cell, and special molecular structures serve to transmit electrical or electrochemical signals across the gap. Some synaptic junctions appear along the length of an axon as it extends; these are called en passant («in passing») synapses and can be in the hundreds or even the thousands along one axon.[3] Other synapses appear as terminals at the ends of axonal branches.

A single axon, with all its branches taken together, can innervate multiple parts of the brain and generate thousands of synaptic terminals. A bundle of axons make a nerve tract in the central nervous system,[4] and a fascicle in the peripheral nervous system. In placental mammals the largest white matter tract in the brain is the corpus callosum, formed of some 200 million axons in the human brain.[4]

Anatomy[edit]

A typical myelinated axon

Axons are the primary transmission lines of the nervous system, and as bundles they form nerves. Some axons can extend up to one meter or more while others extend as little as one millimeter. The longest axons in the human body are those of the sciatic nerve, which run from the base of the spinal cord to the big toe of each foot. The diameter of axons is also variable. Most individual axons are microscopic in diameter (typically about one micrometer (µm) across). The largest mammalian axons can reach a diameter of up to 20 µm. The squid giant axon, which is specialized to conduct signals very rapidly, is close to 1 millimeter in diameter, the size of a small pencil lead. The numbers of axonal telodendria (the branching structures at the end of the axon) can also differ from one nerve fiber to the next. Axons in the central nervous system (CNS) typically show multiple telodendria, with many synaptic end points. In comparison, the cerebellar granule cell axon is characterized by a single T-shaped branch node from which two parallel fibers extend. Elaborate branching allows for the simultaneous transmission of messages to a large number of target neurons within a single region of the brain.

There are two types of axons in the nervous system: myelinated and unmyelinated axons.[5] Myelin is a layer of a fatty insulating substance, which is formed by two types of glial cells: Schwann cells and oligodendrocytes. In the peripheral nervous system Schwann cells form the myelin sheath of a myelinated axon. Oligodendrocytes form the insulating myelin in the CNS. Along myelinated nerve fibers, gaps in the myelin sheath known as nodes of Ranvier occur at evenly spaced intervals. The myelination enables an especially rapid mode of electrical impulse propagation called saltatory conduction.

The myelinated axons from the cortical neurons form the bulk of the neural tissue called white matter in the brain. The myelin gives the white appearance to the tissue in contrast to the grey matter of the cerebral cortex which contains the neuronal cell bodies. A similar arrangement is seen in the cerebellum. Bundles of myelinated axons make up the nerve tracts in the CNS. Where these tracts cross the midline of the brain to connect opposite regions they are called commissures. The largest of these is the corpus callosum that connects the two cerebral hemispheres, and this has around 20 million axons.[4]

The structure of a neuron is seen to consist of two separate functional regions, or compartments – the cell body together with the dendrites as one region, and the axonal region as the other.

Axonal region[edit]

The axonal region or compartment, includes the axon hillock, the initial segment, the rest of the axon, and the axon telodendria, and axon terminals. It also includes the myelin sheath. The Nissl bodies that produce the neuronal proteins are absent in the axonal region.[3] Proteins needed for the growth of the axon, and the removal of waste materials, need a framework for transport. This axonal transport is provided for in the axoplasm by arrangements of microtubules and intermediate filaments known as neurofilaments.

Axon hillock[edit]

Detail showing microtubules at axon hillock and initial segment.

The axon hillock is the area formed from the cell body of the neuron as it extends to become the axon. It precedes the initial segment. The received action potentials that are summed in the neuron are transmitted to the axon hillock for the generation of an action potential from the initial segment.

Axonal initial segment[edit]

The axonal initial segment (AIS) is a structurally and functionally separate microdomain of the axon.[6][7] One function of the initial segment is to separate the main part of an axon from the rest of the neuron; another function is to help initiate action potentials.[8] Both of these functions support neuron cell polarity, in which dendrites (and, in some cases the soma) of a neuron receive input signals at the basal region, and at the apical region the neuron’s axon provides output signals.[9]

The axon initial segment is unmyelinated and contains a specialized complex of proteins. It is between approximately 20 and 60 µm in length and functions as the site of action potential initiation.[10][11] Both the position on the axon and the length of the AIS can change showing a degree of plasticity that can fine-tune the neuronal output.[10][12] A longer AIS is associated with a greater excitability.[12] Plasticity is also seen in the ability of the AIS to change its distribution and to maintain the activity of neural circuitry at a constant level.[13]

The AIS is highly specialized for the fast conduction of nerve impulses. This is achieved by a high concentration of voltage-gated sodium channels in the initial segment where the action potential is initiated.[13] The ion channels are accompanied by a high number of cell adhesion molecules and scaffolding proteins that anchor them to the cytoskeleton.[10] Interactions with ankyrin G are important as it is the major organizer in the AIS.[10]

Axonal transport[edit]

The axoplasm is the equivalent of cytoplasm in the cell. Microtubules form in the axoplasm at the axon hillock. They are arranged along the length of the axon, in overlapping sections, and all point in the same direction – towards the axon terminals.[14] This is noted by the positive endings of the microtubules. This overlapping arrangement provides the routes for the transport of different materials from the cell body.[14] Studies on the axoplasm has shown the movement of numerous vesicles of all sizes to be seen along cytoskeletal filaments – the microtubules, and neurofilaments, in both directions between the axon and its terminals and the cell body.

Outgoing anterograde transport from the cell body along the axon, carries mitochondria and membrane proteins needed for growth to the axon terminal. Ingoing retrograde transport carries cell waste materials from the axon terminal to the cell body.[15] Outgoing and ingoing tracks use different sets of motor proteins.[14] Outgoing transport is provided by kinesin, and ingoing return traffic is provided by dynein. Dynein is minus-end directed.[15] There are many forms of kinesin and dynein motor proteins, and each is thought to carry a different cargo.[14] The studies on transport in the axon led to the naming of kinesin.[14]

Myelination[edit]

TEM of a myelinated axon in cross-section.

In the nervous system, axons may be myelinated, or unmyelinated. This is the provision of an insulating layer, called a myelin sheath. The myelin membrane is unique in its relatively high lipid to protein ratio.[16]

In the peripheral nervous system axons are myelinated by glial cells known as Schwann cells. In the central nervous system the myelin sheath is provided by another type of glial cell, the oligodendrocyte. Schwann cells myelinate a single axon. An oligodendrocyte can myelinate up to 50 axons.[17]

The composition of myelin is different in the two types. In the CNS the major myelin protein is proteolipid protein, and in the PNS it is myelin basic protein.

Nodes of Ranvier[edit]

Nodes of Ranvier (also known as myelin sheath gaps) are short unmyelinated segments of a myelinated axon, which are found periodically interspersed between segments of the myelin sheath. Therefore, at the point of the node of Ranvier, the axon is reduced in diameter.[18] These nodes are areas where action potentials can be generated. In saltatory conduction, electrical currents produced at each node of Ranvier are conducted with little attenuation to the next node in line, where they remain strong enough to generate another action potential. Thus in a myelinated axon, action potentials effectively «jump» from node to node, bypassing the myelinated stretches in between, resulting in a propagation speed much faster than even the fastest unmyelinated axon can sustain.

Axon terminals[edit]

An axon can divide into many branches called telodendria (Greek for ‘end of tree’). At the end of each telodendron is an axon terminal (also called a synaptic bouton, or terminal bouton). Axon terminals contain synaptic vesicles that store the neurotransmitter for release at the synapse. This makes multiple synaptic connections with other neurons possible. Sometimes the axon of a neuron may synapse onto dendrites of the same neuron, when it is known as an autapse.

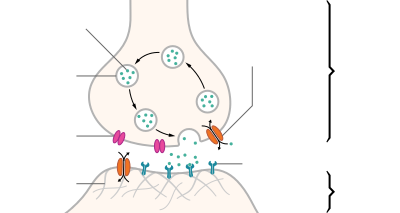

Action potentials[edit]

| Structure of a typical chemical synapse |

|---|

|

Postsynaptic Voltage- Synaptic Neurotransmitter Receptor Neurotransmitter Axon terminal Synaptic cleft Dendrite |

Most axons carry signals in the form of action potentials, which are discrete electrochemical impulses that travel rapidly along an axon, starting at the cell body and terminating at points where the axon makes synaptic contact with target cells. The defining characteristic of an action potential is that it is «all-or-nothing» – every action potential that an axon generates has essentially the same size and shape. This all-or-nothing characteristic allows action potentials to be transmitted from one end of a long axon to the other without any reduction in size. There are, however, some types of neurons with short axons that carry graded electrochemical signals, of variable amplitude.

When an action potential reaches a presynaptic terminal, it activates the synaptic transmission process. The first step is rapid opening of calcium ion channels in the membrane of the axon, allowing calcium ions to flow inward across the membrane. The resulting increase in intracellular calcium concentration causes synaptic vesicles (tiny containers enclosed by a lipid membrane) filled with a neurotransmitter chemical to fuse with the axon’s membrane and empty their contents into the extracellular space. The neurotransmitter is released from the presynaptic nerve through exocytosis. The neurotransmitter chemical then diffuses across to receptors located on the membrane of the target cell. The neurotransmitter binds to these receptors and activates them. Depending on the type of receptors that are activated, the effect on the target cell can be to excite the target cell, inhibit it, or alter its metabolism in some way. This entire sequence of events often takes place in less than a thousandth of a second. Afterward, inside the presynaptic terminal, a new set of vesicles is moved into position next to the membrane, ready to be released when the next action potential arrives. The action potential is the final electrical step in the integration of synaptic messages at the scale of the neuron.[5]

(A) pyramidal cell, interneuron, and short durationwaveform (Axon), overlay of the three average waveforms;

(B) Average and standard error of peak-trough time for pyramidal cells interneurons, and putative axons;

(C) Scatter plot of signal to noise ratios for individual units againstpeak-trough time for axons, pyramidal cells (PYR) and interneurons (INT).

Extracellular recordings of action potential propagation in axons has been demonstrated in freely moving animals. While extracellular somatic action potentials have been used to study cellular activity in freely moving animals such as place cells, axonal activity in both white and gray matter can also be recorded. Extracellular recordings of axon action potential propagation is distinct from somatic action potentials in three ways: 1. The signal has a shorter peak-trough duration (~150μs) than of pyramidal cells (~500μs) or interneurons (~250μs). 2. The voltage change is triphasic. 3. Activity recorded on a tetrode is seen on only one of the four recording wires. In recordings from freely moving rats, axonal signals have been isolated in white matter tracts including the alveus and the corpus callosum as well hippocampal gray matter.[19]

In fact, the generation of action potentials in vivo is sequential in nature, and these sequential spikes constitute the digital codes in the neurons. Although previous studies indicate an axonal origin of a single spike evoked by short-term pulses, physiological signals in vivo trigger the initiation of sequential spikes at the cell bodies of the neurons.[20][21]

In addition to propagating action potentials to axonal terminals, the axon is able to amplify the action potentials, which makes sure a secure propagation of sequential action potentials toward the axonal terminal. In terms of molecular mechanisms, voltage-gated sodium channels in the axons possess lower threshold and shorter refractory period in response to short-term pulses.[22]

Development and growth[edit]

Development[edit]

The development of the axon to its target, is one of the six major stages in the overall development of the nervous system.[23] Studies done on cultured hippocampal neurons suggest that neurons initially produce multiple neurites that are equivalent, yet only one of these neurites is destined to become the axon.[24] It is unclear whether axon specification precedes axon elongation or vice versa,[25] although recent evidence points to the latter. If an axon that is not fully developed is cut, the polarity can change and other neurites can potentially become the axon. This alteration of polarity only occurs when the axon is cut at least 10 μm shorter than the other neurites. After the incision is made, the longest neurite will become the future axon and all the other neurites, including the original axon, will turn into dendrites.[26] Imposing an external force on a neurite, causing it to elongate, will make it become an axon.[27] Nonetheless, axonal development is achieved through a complex interplay between extracellular signaling, intracellular signaling and cytoskeletal dynamics.

[edit]

The extracellular signals that propagate through the extracellular matrix surrounding neurons play a prominent role in axonal development.[28] These signaling molecules include proteins, neurotrophic factors, and extracellular matrix and adhesion molecules.

Netrin (also known as UNC-6) a secreted protein, functions in axon formation. When the UNC-5 netrin receptor is mutated, several neurites are irregularly projected out of neurons and finally a single axon is extended anteriorly.[29][30][31][32] The neurotrophic factors – nerve growth factor (NGF), brain-derived neurotrophic factor (BDNF) and neurotrophin-3 (NTF3) are also involved in axon development and bind to Trk receptors.[33]

The ganglioside-converting enzyme plasma membrane ganglioside sialidase (PMGS), which is involved in the activation of TrkA at the tip of neutrites, is required for the elongation of axons. PMGS asymmetrically distributes to the tip of the neurite that is destined to become the future axon.[34]

Intracellular signaling[edit]

During axonal development, the activity of PI3K is increased at the tip of destined axon. Disrupting the activity of PI3K inhibits axonal development. Activation of PI3K results in the production of phosphatidylinositol (3,4,5)-trisphosphate (PtdIns) which can cause significant elongation of a neurite, converting it into an axon. As such, the overexpression of phosphatases that dephosphorylate PtdIns leads into the failure of polarization.[28]

Cytoskeletal dynamics[edit]

The neurite with the lowest actin filament content will become the axon. PGMS concentration and f-actin content are inversely correlated; when PGMS becomes enriched at the tip of a neurite, its f-actin content is substantially decreased.[34] In addition, exposure to actin-depolimerizing drugs and toxin B (which inactivates Rho-signaling) causes the formation of multiple axons. Consequently, the interruption of the actin network in a growth cone will promote its neurite to become the axon.[35]

Growth[edit]

Axon of nine-day-old mouse with growth cone visible

Growing axons move through their environment via the growth cone, which is at the tip of the axon. The growth cone has a broad sheet-like extension called a lamellipodium which contain protrusions called filopodia. The filopodia are the mechanism by which the entire process adheres to surfaces and explores the surrounding environment. Actin plays a major role in the mobility of this system. Environments with high levels of cell adhesion molecules (CAMs) create an ideal environment for axonal growth. This seems to provide a «sticky» surface for axons to grow along. Examples of CAMs specific to neural systems include N-CAM, TAG-1 – an axonal glycoprotein[36] – and MAG, all of which are part of the immunoglobulin superfamily. Another set of molecules called extracellular matrix-adhesion molecules also provide a sticky substrate for axons to grow along. Examples of these molecules include laminin, fibronectin, tenascin, and perlecan. Some of these are surface bound to cells and thus act as short range attractants or repellents. Others are difusible ligands and thus can have long range effects.

Cells called guidepost cells assist in the guidance of neuronal axon growth. These cells that help axon guidance, are typically other neurons that are sometimes immature. When the axon has completed its growth at its connection to the target, the diameter of the axon can increase by up to five times, depending on the speed of conduction required.[37]

It has also been discovered through research that if the axons of a neuron were damaged, as long as the soma (the cell body of a neuron) is not damaged, the axons would regenerate and remake the synaptic connections with neurons with the help of guidepost cells. This is also referred to as neuroregeneration.[38]

Nogo-A is a type of neurite outgrowth inhibitory component that is present in the central nervous system myelin membranes (found in an axon). It has a crucial role in restricting axonal regeneration in adult mammalian central nervous system. In recent studies, if Nogo-A is blocked and neutralized, it is possible to induce long-distance axonal regeneration which leads to enhancement of functional recovery in rats and mouse spinal cord. This has yet to be done on humans.[39] A recent study has also found that macrophages activated through a specific inflammatory pathway activated by the Dectin-1 receptor are capable of promoting axon recovery, also however causing neurotoxicity in the neuron.[40]

Length regulation[edit]

Axons vary largely in length from a few micrometers up to meters in some animals. This emphasizes that there must be a cellular length regulation mechanism allowing the neurons both to sense the length of their axons and to control their growth accordingly. It was discovered that motor proteins play an important role in regulating the length of axons.[41] Based on this observation, researchers developed an explicit model for axonal growth describing how motor proteins could affect the axon length on the molecular level.[42][43][44][45] These studies suggest that motor proteins carry signaling molecules from the soma to the growth cone and vice versa whose concentration oscillates in time with a length-dependent frequency.

Classification[edit]

The axons of neurons in the human peripheral nervous system can be classified based on their physical features and signal conduction properties. Axons were known to have different thicknesses (from 0.1 to 20 µm)[3] and these differences were thought to relate to the speed at which an action potential could travel along the axon – its conductance velocity. Erlanger and Gasser proved this hypothesis, and identified several types of nerve fiber, establishing a relationship between the diameter of an axon and its nerve conduction velocity. They published their findings in 1941 giving the first classification of axons.

Axons are classified in two systems. The first one introduced by Erlanger and Gasser, grouped the fibers into three main groups using the letters A, B, and C. These groups, group A, group B, and group C include both the sensory fibers (afferents) and the motor fibers (efferents). The first group A, was subdivided into alpha, beta, gamma, and delta fibers – Aα, Aβ, Aγ, and Aδ. The motor neurons of the different motor fibers, were the lower motor neurons – alpha motor neuron, beta motor neuron, and gamma motor neuron having the Aα, Aβ, and Aγ nerve fibers, respectively.

Later findings by other researchers identified two groups of Aa fibers that were sensory fibers. These were then introduced into a system that only included sensory fibers (though some of these were mixed nerves and were also motor fibers). This system refers to the sensory groups as Types and uses Roman numerals: Type Ia, Type Ib, Type II, Type III, and Type IV.

Motor[edit]

Lower motor neurons have two kind of fibers:

| Type | Erlanger-Gasser Classification |

Diameter (µm) |

Myelin | Conduction velocity (meters/second) |

Associated muscle fibers |

|---|---|---|---|---|---|

| Alpha (α) motor neuron | Aα | 13–20 | Yes | 80–120 | Extrafusal muscle fibers |

| Beta (β) motor neuron | Aβ | ||||

| Gamma (γ) motor neuron | Aγ | 5-8 | Yes | 4–24[46][47] | Intrafusal muscle fibers |

Sensory[edit]

Different sensory receptors innervate different types of nerve fibers. Proprioceptors are innervated by type Ia, Ib and II sensory fibers, mechanoreceptors by type II and III sensory fibers and nociceptors and thermoreceptors by type III and IV sensory fibers.

| Type | Erlanger-Gasser Classification |

Diameter (µm) |

Myelin | Conduction velocity (m/s) |

Associated sensory receptors | Proprioceptors | Mechanoceptors | Nociceptors and thermoreceptors |

|---|---|---|---|---|---|---|---|---|

| Ia | Aα | 13–20 | Yes | 80–120 | Primary receptors of muscle spindle (annulospiral ending) | ✔ | ||

| Ib | Aα | 13–20 | Yes | 80–120 | Golgi tendon organ | |||

| II | Aβ | 6–12 | Yes | 33–75 | Secondary receptors of muscle spindle (flower-spray ending). All cutaneous mechanoreceptors |

✔ | ||

| III | Aδ | 1–5 | Thin | 3–30 | Free nerve endings of touch and pressure Nociceptors of lateral spinothalamic tract Cold thermoreceptors |

✔ | ||

| IV | C | 0.2–1.5 | No | 0.5–2.0 | Nociceptors of anterior spinothalamic tract Warmth receptors |

Autonomic[edit]

The autonomic nervous system has two kinds of peripheral fibers:

| Type | Erlanger-Gasser Classification |

Diameter (µm) |

Myelin[48] | Conduction velocity (m/s) |

|---|---|---|---|---|

| preganglionic fibers | B | 1–5 | Yes | 3–15 |

| postganglionic fibers | C | 0.2–1.5 | No | 0.5–2.0 |

Clinical significance[edit]

In order of degree of severity, injury to a nerve can be described as neurapraxia, axonotmesis, or neurotmesis.

Concussion is considered a mild form of diffuse axonal injury.[49] Axonal injury can also cause central chromatolysis. The dysfunction of axons in the nervous system is one of the major causes of many inherited neurological disorders that affect both peripheral and central neurons.[5]

When an axon is crushed, an active process of axonal degeneration takes place at the part of the axon furthest from the cell body. This degeneration takes place quickly following the injury, with the part of the axon being sealed off at the membranes and broken down by macrophages. This is known as Wallerian degeneration.[50] Dying back of an axon can also take place in many neurodegenerative diseases, particularly when axonal transport is impaired, this is known as Wallerian-like degeneration.[51] Studies suggest that the degeneration happens as

a result of the axonal protein NMNAT2, being prevented from reaching all of the axon.[52]

Demyelination of axons causes the multitude of neurological symptoms found in the disease multiple sclerosis.

Dysmyelination is the abnormal formation of the myelin sheath. This is implicated in several leukodystrophies, and also in schizophrenia.[53][54][55]

A severe traumatic brain injury can result in widespread lesions to nerve tracts damaging the axons in a condition known as diffuse axonal injury. This can lead to a persistent vegetative state.[56] It has been shown in studies on the rat that axonal damage from a single mild traumatic brain injury, can leave a susceptibility to further damage, after repeated mild traumatic brain injuries.[57]

A nerve guidance conduit is an artificial means of guiding axon growth to enable neuroregeneration, and is one of the many treatments used for different kinds of nerve injury.

History[edit]

German anatomist Otto Friedrich Karl Deiters is generally credited with the discovery of the axon by distinguishing it from the dendrites.[5] Swiss Rüdolf Albert von Kölliker and German Robert Remak were the first to identify and characterize the axon initial segment. Kölliker named the axon in 1896.[58] Louis-Antoine Ranvier was the first to describe the gaps or nodes found on axons and for this contribution these axonal features are now commonly referred to as the nodes of Ranvier. Santiago Ramón y Cajal, a Spanish anatomist, proposed that axons were the output components of neurons, describing their functionality.[5] Joseph Erlanger and Herbert Gasser earlier developed the classification system for peripheral nerve fibers,[59] based on axonal conduction velocity, myelination, fiber size etc. Alan Hodgkin and Andrew Huxley also employed the squid giant axon (1939) and by 1952 they had obtained a full quantitative description of the ionic basis of the action potential, leading to the formulation of the Hodgkin–Huxley model. Hodgkin and Huxley were awarded jointly the Nobel Prize for this work in 1963. The formulae detailing axonal conductance were extended to vertebrates in the Frankenhaeuser–Huxley equations. The understanding of the biochemical basis for action potential propagation has advanced further, and includes many details about individual ion channels.

Other animals[edit]

The axons in invertebrates have been extensively studied. The longfin inshore squid, often used as a model organism has the longest known axon.[60] The giant squid has the largest axon known. Its size ranges from 0.5 (typically) to 1 mm in diameter and is used in the control of its jet propulsion system. The fastest recorded conduction speed of 210 m/s, is found in the ensheathed axons of some pelagic Penaeid shrimps[61] and the usual range is between 90 and 200 meters/s[62] (cf 100–120 m/s for the fastest myelinated vertebrate axon.)

In other cases as seen in rat studies an axon originates from a dendrite; such axons are said to have «dendritic origin». Some axons with dendritic origin similarly have a «proximal» initial segment that starts directly at the axon origin, while others have a «distal» initial segment, discernibly separated from the axon origin.[63] In many species some of the neurons have axons that emanate from the dendrite and not from the cell body, and these are known as axon-carrying dendrites.[1] In many cases, an axon originates at an axon hillock on the soma; such axons are said to have «somatic origin». Some axons with somatic origin have a «proximal» initial segment adjacent the axon hillock, while others have a «distal» initial segment, separated from the soma by an extended axon hillock.[63]

See also[edit]

- Electrophysiology

- Ganglionic eminence

- Giant axonal neuropathy

- Neuronal tracing

- Pioneer axon

References[edit]

- ^ a b Triarhou LC (2014). «Axons emanating from dendrites: phylogenetic repercussions with Cajalian hues». Frontiers in Neuroanatomy. 8: 133. doi:10.3389/fnana.2014.00133. PMC 4235383. PMID 25477788.

- ^ Yau KW (December 1976). «Receptive fields, geometry and conduction block of sensory neurones in the central nervous system of the leech». The Journal of Physiology. 263 (3): 513–38. doi:10.1113/jphysiol.1976.sp011643. PMC 1307715. PMID 1018277.

- ^ a b c Squire, Larry (2013). Fundamental neuroscience (4th ed.). Amsterdam: Elsevier/Academic Press. pp. 61–65. ISBN 978-0-12-385-870-2.

- ^ a b c Luders E, Thompson PM, Toga AW (August 2010). «The development of the corpus callosum in the healthy human brain». The Journal of Neuroscience. 30 (33): 10985–90. doi:10.1523/JNEUROSCI.5122-09.2010. PMC 3197828. PMID 20720105.

- ^ a b c d e Debanne D, Campanac E, Bialowas A, Carlier E, Alcaraz G (April 2011). «Axon physiology» (PDF). Physiological Reviews. 91 (2): 555–602. doi:10.1152/physrev.00048.2009. PMID 21527732. S2CID 13916255.

- ^ Nelson AD, Jenkins PM (2017). «Axonal Membranes and Their Domains: Assembly and Function of the Axon Initial Segment and Node of Ranvier». Frontiers in Cellular Neuroscience. 11: 136. doi:10.3389/fncel.2017.00136. PMC 5422562. PMID 28536506.

- ^ Leterrier C, Clerc N, Rueda-Boroni F, Montersino A, Dargent B, Castets F (2017). «Ankyrin G Membrane Partners Drive the Establishment and Maintenance of the Axon Initial Segment». Frontiers in Cellular Neuroscience. 11: 6. doi:10.3389/fncel.2017.00006. PMC 5266712. PMID 28184187.

- ^ Leterrier C (February 2018). «The Axon Initial Segment: An Updated Viewpoint». The Journal of Neuroscience. 38 (9): 2135–2145. doi:10.1523/jneurosci.1922-17.2018. PMC 6596274. PMID 29378864.

- ^ Rasband MN (August 2010). «The axon initial segment and the maintenance of neuronal polarity». Nature Reviews. Neuroscience. 11 (8): 552–62. doi:10.1038/nrn2852. PMID 20631711. S2CID 23996233.

- ^ a b c d Jones SL, Svitkina TM (2016). «Axon Initial Segment Cytoskeleton: Architecture, Development, and Role in Neuron Polarity». Neural Plasticity. 2016: 6808293. doi:10.1155/2016/6808293. PMC 4967436. PMID 27493806.

- ^ Clark BD, Goldberg EM, Rudy B (December 2009). «Electrogenic tuning of the axon initial segment». The Neuroscientist. 15 (6): 651–68. doi:10.1177/1073858409341973. PMC 2951114. PMID 20007821.

- ^ a b Yamada R, Kuba H (2016). «Structural and Functional Plasticity at the Axon Initial Segment». Frontiers in Cellular Neuroscience. 10: 250. doi:10.3389/fncel.2016.00250. PMC 5078684. PMID 27826229.

- ^ a b Susuki K, Kuba H (March 2016). «Activity-dependent regulation of excitable axonal domains». The Journal of Physiological Sciences. 66 (2): 99–104. doi:10.1007/s12576-015-0413-4. PMID 26464228. S2CID 18862030.

- ^ a b c d e Alberts B (2004). Essential cell biology: an introduction to the molecular biology of the cell (2nd ed.). New York: Garland. pp. 584–587. ISBN 978-0-8153-3481-1.

- ^ a b Alberts B (2002). Molecular biology of the cell (4th ed.). New York: Garland. pp. 979–981. ISBN 978-0-8153-4072-0.

- ^ Ozgen, H; Baron, W; Hoekstra, D; Kahya, N (September 2016). «Oligodendroglial membrane dynamics in relation to myelin biogenesis». Cellular and Molecular Life Sciences. 73 (17): 3291–310. doi:10.1007/s00018-016-2228-8. PMC 4967101. PMID 27141942.

- ^ Sadler, T. (2010). Langman’s medical embryology (11th ed.). Philadelphia: Lippincott William & Wilkins. p. 300. ISBN 978-0-7817-9069-7.

- ^ Hess A, Young JZ (November 1952). «The nodes of Ranvier». Proceedings of the Royal Society of London. Series B, Biological Sciences. Series B. 140 (900): 301–20. Bibcode:1952RSPSB.140..301H. doi:10.1098/rspb.1952.0063. JSTOR 82721. PMID 13003931. S2CID 11963512.

- ^ Robbins AA, Fox SE, Holmes GL, Scott RC, Barry JM (November 2013). «Short duration waveforms recorded extracellularly from freely moving rats are representative of axonal activity». Frontiers in Neural Circuits. 7 (181): 181. doi:10.3389/fncir.2013.00181. PMC 3831546. PMID 24348338.

- ^ Rongjing Ge, Hao Qian and Jin-Hui Wang* (2011) Molecular Brain 4(19), 1~11

- ^ Rongjing Ge, Hao Qian, Na Chen and Jin-Hui Wang* (2014) Molecular Brain 7(26):1-16

- ^ Chen N, Yu J, Qian H, Ge R, Wang JH (July 2010). «Axons amplify somatic incomplete spikes into uniform amplitudes in mouse cortical pyramidal neurons». PLOS ONE. 5 (7): e11868. Bibcode:2010PLoSO…511868C. doi:10.1371/journal.pone.0011868. PMC 2912328. PMID 20686619.

- ^ Wolpert, Lewis (2015). Principles of development (5th ed.). pp. 520–524. ISBN 978-0-19-967814-3.

- ^ Fletcher TL, Banker GA (December 1989). «The establishment of polarity by hippocampal neurons: the relationship between the stage of a cell’s development in situ and its subsequent development in culture». Developmental Biology. 136 (2): 446–54. doi:10.1016/0012-1606(89)90269-8. PMID 2583372.

- ^ Jiang H, Rao Y (May 2005). «Axon formation: fate versus growth». Nature Neuroscience. 8 (5): 544–6. doi:10.1038/nn0505-544. PMID 15856056. S2CID 27728967.

- ^ Goslin K, Banker G (April 1989). «Experimental observations on the development of polarity by hippocampal neurons in culture». The Journal of Cell Biology. 108 (4): 1507–16. doi:10.1083/jcb.108.4.1507. PMC 2115496. PMID 2925793.

- ^ Lamoureux P, Ruthel G, Buxbaum RE, Heidemann SR (November 2002). «Mechanical tension can specify axonal fate in hippocampal neurons». The Journal of Cell Biology. 159 (3): 499–508. doi:10.1083/jcb.200207174. PMC 2173080. PMID 12417580.

- ^ a b Arimura N, Kaibuchi K (March 2007). «Neuronal polarity: from extracellular signals to intracellular mechanisms». Nature Reviews. Neuroscience. 8 (3): 194–205. doi:10.1038/nrn2056. PMID 17311006. S2CID 15556921.

- ^ Neuroglia and pioneer neurons express UNC-6 to provide global and local netrin cues for guiding migrations in C. elegans

- ^ Serafini T, Kennedy TE, Galko MJ, Mirzayan C, Jessell TM, Tessier-Lavigne M (August 1994). «The netrins define a family of axon outgrowth-promoting proteins homologous to C. elegans UNC-6». Cell. 78 (3): 409–24. doi:10.1016/0092-8674(94)90420-0. PMID 8062384. S2CID 22666205.

- ^ Hong K, Hinck L, Nishiyama M, Poo MM, Tessier-Lavigne M, Stein E (June 1999). «A ligand-gated association between cytoplasmic domains of UNC5 and DCC family receptors converts netrin-induced growth cone attraction to repulsion». Cell. 97 (7): 927–41. doi:10.1016/S0092-8674(00)80804-1. PMID 10399920. S2CID 18043414.

- ^ Hedgecock EM, Culotti JG, Hall DH (January 1990). «The unc-5, unc-6, and unc-40 genes guide circumferential migrations of pioneer axons and mesodermal cells on the epidermis in C. elegans». Neuron. 4 (1): 61–85. doi:10.1016/0896-6273(90)90444-K. PMID 2310575. S2CID 23974242.

- ^ Huang EJ, Reichardt LF (2003). «Trk receptors: roles in neuronal signal transduction». Annual Review of Biochemistry. 72: 609–42. doi:10.1146/annurev.biochem.72.121801.161629. PMID 12676795. S2CID 10217268.

- ^ a b Da Silva JS, Hasegawa T, Miyagi T, Dotti CG, Abad-Rodriguez J (May 2005). «Asymmetric membrane ganglioside sialidase activity specifies axonal fate». Nature Neuroscience. 8 (5): 606–15. doi:10.1038/nn1442. PMID 15834419. S2CID 25227765.

- ^ Bradke F, Dotti CG (March 1999). «The role of local actin instability in axon formation». Science. 283 (5409): 1931–4. Bibcode:1999Sci…283.1931B. doi:10.1126/science.283.5409.1931. PMID 10082468.

- ^ Furley AJ, Morton SB, Manalo D, Karagogeos D, Dodd J, Jessell TM (April 1990). «The axonal glycoprotein TAG-1 is an immunoglobulin superfamily member with neurite outgrowth-promoting activity». Cell. 61 (1): 157–70. doi:10.1016/0092-8674(90)90223-2. PMID 2317872. S2CID 28813676.

- ^ Alberts, Bruce (2015). Molecular biology of the cell (Sixth ed.). p. 947. ISBN 9780815344643.